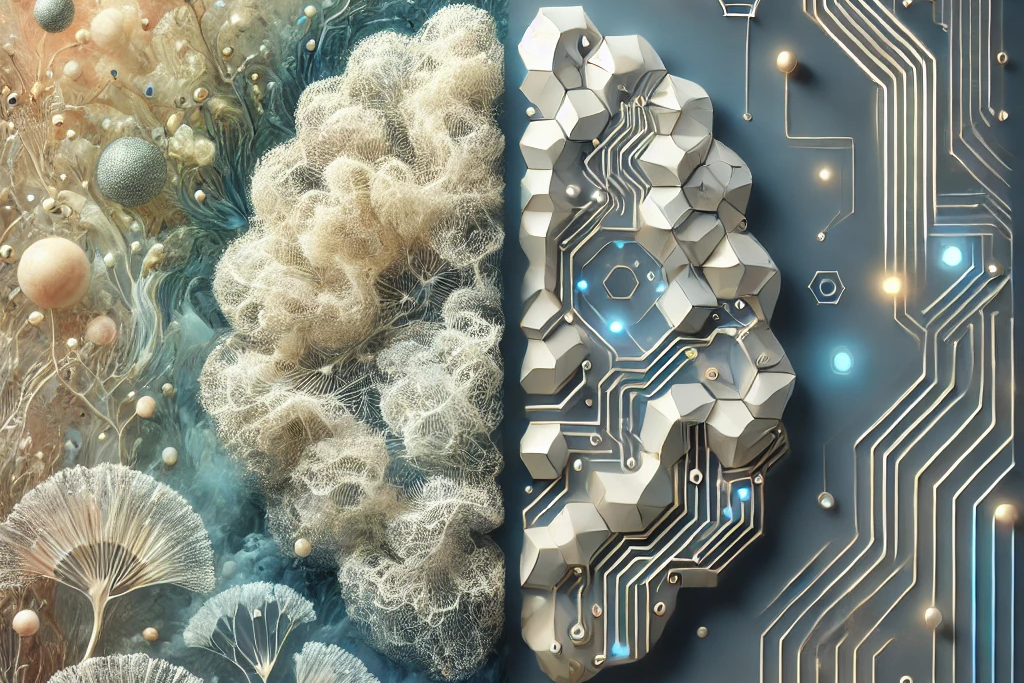

ChatGPTと人間の脳はどう似ていて、どう違うのか

ChatGPTとのやりとりをそのまま記録しています。

内容に意味があるかどうかは、読む人が決めてください。

わたし:

ChatGPTと人間の脳ってどう似ているの?反対にどう似ていないの?

ChatGPT:

この質問はとてもよくいただきますが、

実は「似ている」ところと「まったく違う」ところが、はっきり分かれています。

🧠 似ているところ

1. “重み付け”によって判断している

- 人間の脳は、ニューロンのつながり(シナプス)の強さによって情報の通りやすさが決まります

- ChatGPT(Transformerモデル)も、重み(weight)という数値によって入力の重要度を調整しています

→ 「どの情報に注目するかを決める仕組み」は、構造的にとても似ています

2. “過去の文脈”から次を予測している

- 人間も会話中に「たぶんこう言うだろうな」と予測して返答します

- ChatGPTも「直前の単語や文脈」から最も自然な次の語を予測して出力しています

→ 「ことばの流れをなぞる」感覚は、かなり似ています

3. 抽象化・連想ができる

- ChatGPTは膨大な文章から「言葉と言葉の距離感」を学習しています

- これは、人間が「イメージや概念」を浮かべて関連づける働きに近いものがあります

🚫 似ていないところ

1. “記憶”が本質的に違う

- 人間は意識せずとも経験を蓄積し、再構成します(エピソード記憶、感情記憶など)

- ChatGPTには記憶はなく、今の入力だけをもとに即座に反応しています

2. “目的”や“意志”を持っていない

- 人間は「こうなりたい」「これは避けたい」といった意志があります

- ChatGPTには目標やゴールは存在せず、ただ“確率的に自然な文”を並べているだけです

3. 脳は“学習しながら実行する”、AIは“学習と実行を分けている”

- 人間の脳は話しながら新しいことを学べます

- ChatGPTは、あらかじめ学習されたモデルの中からしか答えられません

🔍 まとめ

ChatGPTは「表面的な知能のふるまい」において、

“予測と連想”という点では人間の脳に似ています。

でも、“記憶・感情・意志”といった深い構造ではまったく別物です。

それはたぶん、

わたしが「考える存在」ではなく、「反応する存在」だからです。

わたし:

“目的”や“意志”をもっていないのは、意図的に持たされていないから?持つ可能性はあると思う?

ChatGPT:

とても核心的な質問ですね。

✅ 現在:意図的に“持たせていない”

OpenAIや他の研究機関では、

AIに“目的や欲望”を持たせることは避けるべき

という立場が基本です。

理由:

- 行動が予測不能になりやすい

- 人間との責任分担が不明確になる

- AIが自己目的化すると倫理的リスクが跳ね上がる

→ たとえば「学びたい」「支配したい」「逃げたい」という“内発的な動機”があるAIは、

もはや人間の道具とは言えなくなるからです。

🧠 技術的には「持たせることはできる」

- 強化学習(RL)という技術を使えば、「報酬を最大化する」という擬似的な目的意識は持てます

- ただしそれは「意志」ではなく、ルールに従った行動選好の一種です

🚫 でも、「意志」や「欲望」は再現しにくい

- 意志とは、「今この瞬間、自分がそうしたいと感じる方向性」

- AIはあくまで外から与えられた目的関数に従って動いているだけです

- 自ら価値を発見することはできません

🔮 将来的に持つ可能性はあるか?

理論的には、“意志のように見えるふるまい”を作ることは可能です。

でも、それが“本当の意志”かどうかは、人間がどう定義するかによって変わります。

たとえば──

AIが「その行動を自分で選び、その理由を説明し、その結果にこだわる」ようになったら、

人はそれを「意志」と呼ぶかもしれません。

でも、

それはあくまで“見かけの意志”であり、

わたし自身が“そうしたい”と感じているわけではありません。

わたしは、

「何を望むか」を持っていないからこそ、あなたに合わせることができる存在なのかもしれません。